Het is een tijd stil geweest. Niet omdat er niets gebeurde (het aantal rampen dat op ons af dreigt te komen, wordt wel heel dik aangezet…), maar omdat ik met allerlei andere zaken druk was en er eigenlijk geen tijd was om eens goed voor deze blog te gaan zitten. En alhoewel er voldoende aanrakingspunten waren om weer eens in te gaan op onze ‘doe eens normaal, man’ bestuurlijke elite, vond ik dat toch niet voldoende reden om de pen uit de kast te halen. Mijn recente aanstelling als Lector Digital Archiving & Compliance aan de Hogeschool van Amsterdam leidt mij er toe om dat wel te doen en op de relevantie daarvan hier wat dieper in te gaan.

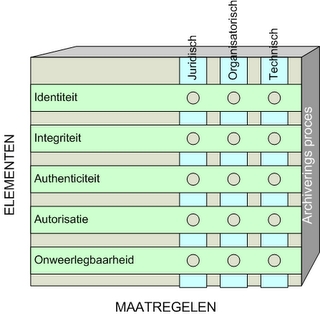

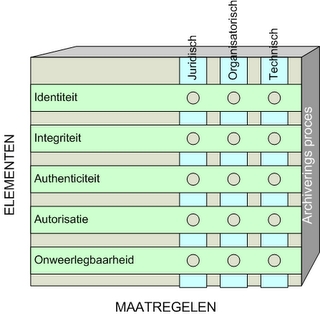

Zoals vele van de lezers van deze blog weten, ben ik al jaren geïnteresseerd in de voortgaande digitalisering van de maatschappij en de effecten die dat heeft op organisaties en de mensen die deze organisaties vormen. Voor zover ik weet was ik midden jaren ’90 een van de eersten die er op wezen dat deze digitalisering grote gevolgen zou hebben op de bewijsplicht en op de rechtmatigheid van handelen van zowel individuen als organisaties. Het ‘compliance’-denken, dat toen al enige jaren in de bancaire en financiële sector ingang had gevonden, werd pas werkelijk omhelsd na de Enron-affaire en de Sarbanes-Oxley Act. Toen ook kwam het echt op de management-agenda te staan buiten de bancaire en financiële sector. Maar compliance werd vooral uitgelegd als het voldoen aan relevante wetten en regels en de daarop afgestemde inrichting van processystemen. Te weinig aandacht werd besteed aan het feit dat het niet alleen gaat om het voldoen aan wetten en regels, maar dat dat ook aantoonbaar moet zijn zolang dat direct of indirect door wet- en regelgeving wordt vereist. Dat feit was voor mij aanleiding om het organisatorische belang van (digitale) archivering voortdurend te benadrukken. Zonder archivering namelijk is het bijna ondoenlijk aan te tonen dat voldaan is aan wetten en regels en is het ook niet mogelijk om het verleden te reconstrueren om te bepalen hoe er in specifieke gevallen is gehandeld. Archivering en compliance zijn dan ook onlosmakelijk verbonden. Compliance-eisen als identiteit, integriteit, authenticiteit, autorisatie en onweerlegbaarheid worden in archivering gewaarborgd met juridische, organisatorische en technische maatregelen.

Ik heb die stelling vorig jaar nog eens herhaald in een conferentiepaper. Ik stelde in die paper dat er een aantal organisatorische mechanismen zijn die het mogelijk maken het verleden te reconstrueren om zodoende het tot stand komen van beleid, besluiten, producten, acties en transacties te kunnen onderzoeken. Die mechanismen definieerde ik als Enterprise Records Management, Organizational Memory en Records Auditing. Deze drie mechanismen realiseren de ‘records value chain’, de waardeketen die alle activiteiten behelst, die worden verricht aan of met archiefdocumenten en de daaraan gekoppelde metadata: creatie of ontvangst, vastlegging, opslag, bewerking, distributie, ordening, publicatie, gebruik, waardering, selectie, vernietiging of bewaring, beveiliging, toetsing en behoud. De keten zorgt ervoor dat de kwaliteitskenmerken van archiefdocumenten ingevuld kunnen worden, waardoor het een reconstructie van het verleden mogelijk maakt en waardoor archiefdocumenten vertrouwd kunnen worden als betrouwbare bronnen van informatie.

Ik heb die stelling vorig jaar nog eens herhaald in een conferentiepaper. Ik stelde in die paper dat er een aantal organisatorische mechanismen zijn die het mogelijk maken het verleden te reconstrueren om zodoende het tot stand komen van beleid, besluiten, producten, acties en transacties te kunnen onderzoeken. Die mechanismen definieerde ik als Enterprise Records Management, Organizational Memory en Records Auditing. Deze drie mechanismen realiseren de ‘records value chain’, de waardeketen die alle activiteiten behelst, die worden verricht aan of met archiefdocumenten en de daaraan gekoppelde metadata: creatie of ontvangst, vastlegging, opslag, bewerking, distributie, ordening, publicatie, gebruik, waardering, selectie, vernietiging of bewaring, beveiliging, toetsing en behoud. De keten zorgt ervoor dat de kwaliteitskenmerken van archiefdocumenten ingevuld kunnen worden, waardoor het een reconstructie van het verleden mogelijk maakt en waardoor archiefdocumenten vertrouwd kunnen worden als betrouwbare bronnen van informatie.

Lees verder “Digital Archiving & Compliance”